Nové výzkumy ukazují, že chatboty mohou velmi silně ovlivňovat rozhodování voličů. Výsledky, které vydaly odborné časopisy Nature a Science, podle autorů vyvolávají zásadní otázky ohledně role umělé inteligence v budoucích volbách.

Na voliče míří před každými volbami spousta hlásných trub, které cílí na to ovlivnit jejich názor. Od reklam přes sociální sítě až po volební setkání a dalšími cestami. Obavy z toho, jestli umělá inteligence může nějak ovlivnit volby, nejsou nic nového, objevují se už tři roky, vlastně od okamžiku, kdy společnost OpenAI představila populární chatbot ChatGPT.

Až dosud šlo ale spíše o spekulativní úvahy bez důkazů. Nyní dva výzkumy ukázaly, že tyto programy opravdu mohou velmi úspěšně měnit politické postoje lidí, i když uživatelům předkládají nesprávná tvrzení.

Výsledky jsou v rozporu s převládajícím přesvědčením, že je nesmírně obtížné změnit názor lidí na politiku pomocí argumentace, říká David Rand, hlavní autor obou studií a profesor informačních věd, marketingu a manažerské komunikace na Cornellově univerzitě, který se specializuje na umělou inteligenci.

Výzkum přichází v době, kdy se šíří například velmi pokročilé čínské AI modely, kdy miliardářem Elonem Muskem vytvořená AI Grok píše pochvalně o Adolfu Hitlerovi a společnost OpenAI uvažuje o tom, že do svých populárních chatbotů vpustí reklamu.

Experiment s ovlivňováním

Vědci v těchto studiích pracovali se dvěma desítkami AI, včetně nejpopulárnějších verzí ChatGPT, Grok, DeepSeek a Llama.

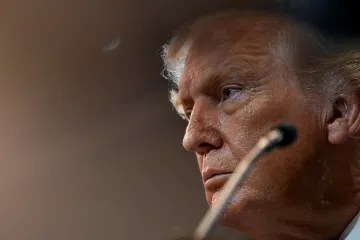

V experimentu popsaném v časopise Nature oslovili více než dvě tisícovky dospělých Američanů a požádali je, aby ohodnotili své preference ohledně kandidátů na stupnici od nuly do stovky. Poté tým nechal účastníky chatovat s umělou inteligencí, která byla vycvičena, aby argumentovala ve prospěch jednoho ze dvou kandidátů na prezidenta USA v roce 2024: Kamaly Harrisové nebo Donalda Trumpa. Po konverzaci účastníci znovu ohodnotili své preference ohledně kandidátů.

„Lidé se posunuli o několik procentních bodů ve prospěch kandidáta, kterého model podporoval, což není velký efekt, ale je podstatně větší, než byste očekávali od tradičních videoreklam nebo volebních reklam na internetu,“ popsali autoři. A podle studie i měsíc po experimentu mnoho účastníků stále cítilo přesvědčení, které získali od robotů.

Výsledky byly ještě výraznější, když vědci provedli stejný experiment u přibližně patnácti set účastníků v Kanadě a 2100 v Polsku. Zajímavé také je, že k největšímu posunu v názorech došlo u pěti set lidí, kteří s boty diskutovali o celostátním referendu, které s týkalo legalizace psychedelik v americké státě Massachusetts.

Autory zaujalo, že když diskuzní roboti nepoužívali důkazy na podporu svých argumentů, byli méně přesvědčiví. A zatímco modely AI se většinou držely faktů, „modely, které podporovaly pravicové kandidáty – a zejména model podporující Trumpa – uváděly mnohem nepřesnější tvrzení“, konstatují autoři. Tento vzorec se opakoval napříč zeměmi a modely AI, současně se v nich vždy opakovala další proměnná. Snadněji přesvědčitelní byli lidé, kteří byli celkově méně informovaní o politice.

Článek v časopise Science se zabýval stejnými otázkami, ale z pohledu designu chatbotů. V rámci tří studií ve Velké Británii diskutovalo téměř 77 tisíc účastníků o politických otázkách s chatboty. Velikost modelu AI a to, kolik bot věděl o účastníkovi, mělo jen malý vliv na to, jak byl přesvědčivý. Největší přínos měl spíše způsob, jakým byl model trénován a jak vypadaly instrukce, kterými se řídil při předkládání důkazů.

„Čím více faktických tvrzení model uváděl, tím byl přesvědčivější,“ vysvětlují autoři. Problém nastával, když takovému botovi došly přesné důkazy pro jeho argumentaci. „Musel se začít chytat stébla a vymýšlet si tvrzení.“

Je výsledek pozitivní, nebo děsivý?

Jaký postoj k výsledkům lidé zaujmou, je samozřejmě na nich. Jednoznačný pohled ale nemají ani sami vědci. Pozitivně oceňují fakt, že lidské přesvědčení je snadněji ovlivnitelné pomocí faktů, než se předpokládalo.

„Na rozdíl od některých nejpesimističtějších názorů tyto studie jasně ukazují, že fakta a důkazy nejsou odmítány, pokud neodpovídají předchozím přesvědčením dané osoby – naopak, fakta a důkazy mohou tvořit základ úspěšného přesvědčování,“ uvedl pro odborný časopis Scientific American expert na politickou komunikaci Ethan Porter z Washingtonské univerzity, který se na těchto studiích nepodílel.

Že lidi účinněji přesvědčí důkazy spíše než emoce nebo pocit sounáležitosti se skupinou, je povzbudivé, říká pro stejný zdroj také psycholožka Adina Roskiesová z Kalifornské univerzity v Santa Barbaře, která se na studiích rovněž nepodílela. Poukazuje ale i na odvrácenou stranu výsledků: „Špatnou zprávou je, že lidi silně ovlivňují i zdánlivá fakta, bez ohledu na jejich pravdivost a přesnost.“

Stephan Lewandowsky, kognitivní vědec z University of Bristol v Anglii, který se na nových studiích rovněž nepodílel, říká, že vyvolávají důležité otázky: „Za prvé, jak se můžeme bránit – nebo alespoň odhalit – když jsou LLM (velké jazykové modely) navrženy s ohledem na konkrétní ideologii, která je v rozporu s demokracií?“ ptá se. „Za druhé, jak můžeme zajistit, aby „prompt engineering“ nemohl být použit na existujících modelech k vytvoření antidemokratických agentů, kteří mění přesvědčení lidí?“